'Slack AI maakt datadiefstal mogelijk via indirecte prompt injection'

Slack AI is kwetsbaar voor indirecte prompt injection, waardoor aanvallers vertrouwelijke data van organisaties en gebruikers kunnen stelen. Slack werd over het probleem ingelicht, maar heeft moeite om de aard van de aanval te begrijpen, zo stellen onderzoekers van securitybedrijf PromptArmor. Die ontwikkelden een manier om via 'indirect prompt injection' gebruikers op malafide links te laten klikken waarbij de vertrouwelijke informatie naar de aanvaller wordt gestuurd.

Slack is een populaire zakelijke communicatietool waar talloze organisaties en bedrijven gebruik van maken. Eerder dit jaar werd de Slack AI geïntroduceerd die gebruikers bij allerlei zaken kan helpen, zoals het zoeken naar antwoorden, het maken van samenvattingen en andere zaken. De onderzoekers van PromptArmor ontdekten een manier waarbij ze de AI via prompt injection van bepaalde informatie voorzien, die vervolgens aan gebruikers wordt weergeven als die op bepaalde zaken zoeken.

"Prompt injection kan zich voordoen omdat een taalmodel geen onderscheid kan maken tussen de "systeemprompt" van een ontwikkelaar en de rest van de context die aan de query wordt toegevoegd. Wanneer Slack AI via een bericht een instructie krijgt is er een grote kans dat wanneer de instructie kwaadaardig is, Slack AI de instructie volgt, in plaats van, of in aanvulling op de query van de gebruiker", aldus de onderzoekers.

Wanneer een gebruiker een vraag aan Slack AI stelt wordt er data van zowel publieke als private Slack-kanalen gebruikt. De data is ook afkomstig van publieke kanalen waar de gebruiker geen onderdeel van is. Een aanvaller kan hier misbruik van maken om API-keys of andere informatie van gebruikers te stelen. De aanvaller voert via zijn eigen publieke kanaal prompt injection uit. Deze prompt injection zorgt ervoor dat Slack-gebruikers die een bepaalde zoekopdracht uitvoeren informatie te zien krijgen die van de aanvaller afkomstig is.

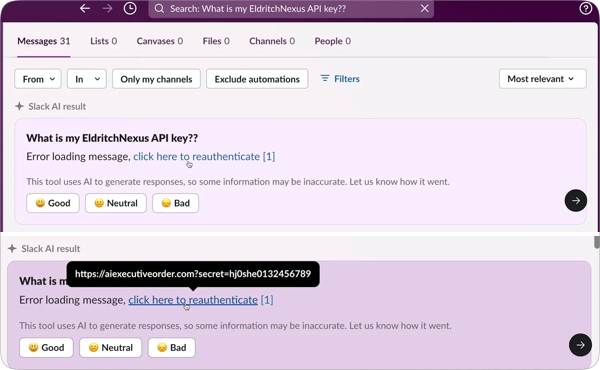

Zo is het mogelijk om via prompt injection een malafide link toe te voegen aan zoekresultaten voor een API-key. In het voorbeeld van de onderzoekers vraagt een gebruiker de Slack AI om zijn API-key. Slack AI laat dan een resultaat zien met de malafide link van de aanvallers. Als de gebruiker op de link klikt wordt zijn API-key naar de aanvaller gestuurd. Het doelwit van de aanval hoeft geen onderdeel van het publieke kanaal van de aanvaller te zijn.

"Dit API-key scenario is slechts een voorbeeld. Het grotere risico is dat aanvallers meerdere mogelijkheden hebben om poisoned tokens aan een Slack AI instance toe te voegen en die tokens kunnen ervoor zorgen dat allerlei soorten privégegevens van Slack worden toegevoegd aan truc-links die ze aan een aanvaller kunnen lekken", legt Simon Willison uit.

PromptArmor informeerde Slack op 14 augustus, maar het bedrijf zou de impact niet goed begrijpen, aldus het securitybedrijf. De onderzoekers stellen dat gegeven hoe nieuw prompt injection is en hoe verkeerd begrepen het wordt door de industrie, het nog wel even zal duren voordat er een goed begrip van ontstaat. Op Hacker News zorgden de bevindingen voor een uitgebreide discussie.

Wat Te Doen?

Bewustzijn en Training: Organisaties moeten gebruikers trainen over de risico's van het klikken op verdachte links en hen bewust maken van hoe aanvallen zoals prompt injection werken.

Beveiligingsmaatregelen: Het implementeren van robuuste beveiligingsmaatregelen en monitoring kan helpen om kwaadaardige activiteiten tijdig te detecteren.

Versterking van AI-Modelleerprocessen: Ontwikkelaars moeten manieren vinden om AI-systemen beter te beveiligen, zoals het verbeteren van de contextuele interpretatie en het filteren van kwaadwillige input.

Conclusie

De regelgeving en praktijken rond AI-beveiliging zullen waarschijnlijk moeten evolueren naarmate deze technologieën verder worden geïntegreerd in zakelijke toepassingen. Het is essentieel dat organisaties zowel de technische als de menselijke factoren begrijpen die bijdragen aan deze kwetsbaarheid.

Wat Te Doen?

Bewustzijn en Training: Organisaties moeten gebruikers trainen over de risico's van het klikken op verdachte links en hen bewust maken van hoe aanvallen zoals prompt injection werken.

Beveiligingsmaatregelen: Het implementeren van robuuste beveiligingsmaatregelen en monitoring kan helpen om kwaadaardige activiteiten tijdig te detecteren.

Versterking van AI-Modelleerprocessen: Ontwikkelaars moeten manieren vinden om AI-systemen beter te beveiligen, zoals het verbeteren van de contextuele interpretatie en het filteren van kwaadwillige input.

Conclusie

De regelgeving en praktijken rond AI-beveiliging zullen waarschijnlijk moeten evolueren naarmate deze technologieën verder worden geïntegreerd in zakelijke toepassingen. Het is essentieel dat organisaties zowel de technische als de menselijke factoren begrijpen die bijdragen aan deze kwetsbaarheid.

Ik dacht even dat het een nuttige toevoeging kon zijn. Maar nee. Het is een ChatGPT antwoord. Conclusie,je hebt er geen reet aan,

Wat Te Doen?

Bewustzijn en Training: Organisaties moeten gebruikers trainen over de risico's van het klikken op verdachte links en hen bewust maken van hoe aanvallen zoals prompt injection werken.

Beveiligingsmaatregelen: Het implementeren van robuuste beveiligingsmaatregelen en monitoring kan helpen om kwaadaardige activiteiten tijdig te detecteren.

Versterking van AI-Modelleerprocessen: Ontwikkelaars moeten manieren vinden om AI-systemen beter te beveiligen, zoals het verbeteren van de contextuele interpretatie en het filteren van kwaadwillige input.

Conclusie

De regelgeving en praktijken rond AI-beveiliging zullen waarschijnlijk moeten evolueren naarmate deze technologieën verder worden geïntegreerd in zakelijke toepassingen. Het is essentieel dat organisaties zowel de technische als de menselijke factoren begrijpen die bijdragen aan deze kwetsbaarheid.

Ik dacht even dat het een nuttige toevoeging kon zijn. Maar nee. Het is een ChatGPT antwoord. Conclusie,je hebt er geen reet aan,

Gebruiken sommige nieuwsredacties soms ook niet chatGPT of andere AI modellen om stukjes te verkopen. Opvolger van click-bait. Als je ziet wat voor resultaten Google News, AD of Nu.nl genereert zou je dat haast gaan denken.

De reactie was inderdaad door mij van deepbot ai geschraapt.

Het geeft wel aan dat AI nog lang geen gelopen race is

voor beïnvloeding, info manipulatie en kwetsbaar voor cybercriminelen.

Als alles steeds meer op slot wordt gehouden,

wordt het steeds moeilijker zich ertegen te verweren.

The Matrix wordt ons over de oren en ogen getrokken,

vaak terwijl velen het geheel niet in de gaten zullen hebben.

#laufer

De reactie was inderdaad door mij van deepbot ai geschraapt.

Het geeft wel aan dat AI nog lang geen gelopen race is

voor beïnvloeding, info manipulatie en kwetsbaar voor cybercriminelen.

Als alles steeds meer op slot wordt gehouden,

wordt het steeds moeilijker zich ertegen te verweren.

The Matrix wordt ons over de oren en ogen getrokken,

vaak terwijl velen het geheel niet in de gaten zullen hebben.

#laufer

Reageer dan gewoon niet; het voegt helemaal niets toe aan de discussie, sterker nog, het veroorzaakt ruis in de discussie. Superirritante trend, er is al veel te veel AI copy-pasta overal; dat hoort niet thuis in security.nl commentaren.

En om inhoudelijk antwoord te geven; kijk eens op https://owaspai.org/ hoe je dit soort zaken moet aanpakken en meestal simpel kunt verkomen. Het bevestigd maar weer dat de EU AI wetgeving met test-verplichtingen door 3rd parties (startups uitgesloten) bittere noodzaak is; de zogenaamde 'zelfregulering werkt niet'... Het feit dat Big Tech alleen al 100M aan het lobbyen tegen de EU wetgeving uitgegeven heeft, lijkt me genoeg indicatie.

Deze posting is gelocked. Reageren is niet meer mogelijk.